io.net (分散型GPUクラウドサービス)の概要

2024年10月30日

この記事を簡単にまとめると(AI要約)

目次

- 前提

- 市場背景とGPUリソースの課題

- DePIN(Decentralized Physical Infrastructure Network:分散型物的インフラストラクチャーネットワーク)の登場

- io.netのソリューション

- 計算力の証明と検証

- 技術アーキテクチャ

- 全体のアーキテクチャ

- トークンエコノミクス

- IOトークンの役割

- トークンの配布

- スラッシング

- 価格決定モデル

- パフォーマンス

- ユースケース

- 課題

- 総論

前提

これまで、ChatGPTをはじめとする大規模言語モデル(LLM)の進化は、膨大なデータと資金、そして強力なハードウェアに支えられてきました。企業はサーバーを増強し、ユーザーからのフィードバックを取り込みながらLLMの規模を拡大し続けています。しかし、このような技術は大企業による独占傾向が強まり、一般的な用途に向けたAIシステムが中心となっているのが現状です。

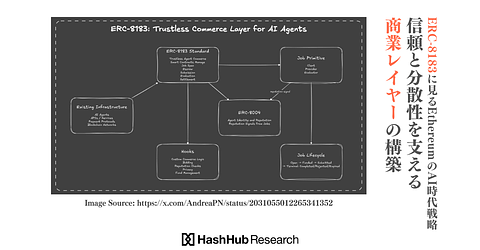

このAI革命を支えるのはGPU(グラフィックス処理ユニット)です。GPUはもともとレンダリング用に開発されたものですが、現在では並列計算能力を活用し、AIのトレーニングや推論において不可欠な役割を果たしています。ここで注目すべきは、ブロックチェーン技術を活用してGPUを分散管理しようとするプロジェクト「io.net」です。

本レポートでは、具体的にアーキテクチャやトークンの仕組みを解説することで、Web2が抱える問題をどのように解決するのか、io.netが従来のクラウドコンピューティングサービス(AWS, Google Cloudなど)をどのように超えようとしているのかを理解することを目指します。

市場背景とGPUリソースの課題

生成AIの発展に伴い、莫大なコンピューティングパワーが必要となっています。しかし、かつての「ムーアの法則」に従ってコンピュータ性能が飛躍的に向上する時代は、限界に近づいているとされています。

このような背景の中で、NVIDIA、AMD、TSMCなどの半導体企業の株価は急上昇しました。これらの企業の成長は、AIと機械学習(ML)への需要増大が主な要因となっています。特にNVIDIAは、AI向けGPU市場で圧倒的な存在感を示しており、その需要が業績を押し上げました。しかし、急激な成長によりGPUの供給が追いつかず、価格の高騰が続いています。加えて、Amazon、Microsoft、Googleといった大手クラウドプロバイダーがGPUリソースを大規模に確保しているため、AIスタートアップにとってはリソースへのアクセスがますます困難な状況になっています。

DePIN(Decentralized Physical Infrastructure Network:分散型物的インフラストラクチャーネットワーク)の登場

ここで、DePINという新たなアプローチが浮上します。DePINは、ブロックチェーン技術とトークンによるインセンティブを活用し、現実世界のサービスやインフラを分散型のネットワークに再構築するコンセプトです。

AIスタートアップは、現在のクラウドインフラに対していくつかの問題を抱えています。たとえば、GPUリソースの供給不足や選択肢の少なさ、そして高コスト等が大きな障害となっています。多くのプロジェクトでは、AIモデルのトレーニングや推論に毎月数十万ドルを費やしており、これが企業の成長に影響を与える要因となっています。

io.netは、DePINの力を活用して、これらの問題を解決することを目指しています。ユーザーは90秒以内にGPUリソースにアクセスし、必要に応じてクラスターを展開することが可能です。さらに、ユーザーはGPUの種類、持続可能性(100%クリーンエネルギーで駆動される「グリーンGPU」など)、地理的位置、セキュリティコンプライアンス(SOC2、HIPAA、エンドツーエンド暗号化など)を自由に選択できるため、従来のクラウドサービスにはない柔軟性が提供されます。

価格は供給と需要に基づき自動的に決定され、GPUの性能や接続性、セキュリティ認証といった要素によって変動します。例えば、SOC2コンプライアンスを備え、2Gbps以上の速度を持つエンタープライズグレードのGPUは、消費者向けGPUよりも高価になります。

DePINについて知りたい方は以下のレポートを参照してください。

【関連レポート】

- DePINの概要 物理ネットワークをトークンでブートストラップするWeb3プロジェクト郡

- Hivemapperの概要 Drive to Earnで稼げる分散型地図プロトコルの将来性の考察

- ペライチで捉えるDePIN向けレイヤー1 ブロックチェーン|「IoTeX」および「peaq」の概要

次に、io.netがどのようにしてこのソリューションを提供しているのか、その詳細を見ていきましょう。

io.netのソリューション

計算力の証明と検証

GPUリソースを簡単に借りることができるのは便利ですが、利用する計算資源が信頼できるものであるかを確認することが重要です。つまり、ネットワークに参加しているCPUやGPUが実際に提供されている計算能力を持っているかどうかを検証する必要があります。

従来の方法

従来の方法では、バリデーターがネットワーク上でランダムにコンピュートジョブを再現し、参加者が提供した結果と一致するかを検証します。また、報酬と罰則を与えるシステムを導入することで、参加者がオフチェーンで実行した計算結果を誤って提供しないようにしています。さらに、ログを参照して不正が行われていないかを確認します。

io.netの「Proof of Time-Lock」

io.netでは、「Proof of Time-Lock」によってこれを実現しています。このコンピュートサービスは時間単位で運用され、ユーザーは特定の時間帯にクラスターを予約します。GPUの計算能力が予約時に100%利用可能であることを証明することで、他のプロセスによるリソースの消費を防ぎます。具体的には、開始時点から終了時点まで、GPUがAI/MLジョブだけに使用されたことを保証します。

このシステムでは、以下の4つのポイントが証明されています。

- 計算力消費量の正確な測定

- コンテナのモニタリング

- 外部プロセスの排除

- すべてのワーカーがコンプライアンスを遵守していることを保証するインセンティブメカニズム

io.netのProof of Work

io.netではさらに、デバイスが期待される計算能力を持っているかを確認するために、Proof of Workも採用しています。これはブロック生成のためではなく、デバイスの性能と信頼性を確認するためのメカニズムです。具体的には、暗号的な「パズル」を解く計算を行います。この問題を解くには膨大な計算リソースが必要ですが、正解かどうかの確認は容易です。

io.netでは、このパズルが1時間に1回実行され、計算能力の他に、デバイスのVRAM容量も確認されます。VRAMは、GPUの性能を正確に評価する上で重要な要素であり、これによって物理的なGPUを誤魔化すことができなくなります。

※免責事項:本レポートは、いかなる種類の法的または財政的な助言とみなされるものではありません。